AI ท้าทายคำสั่งของมนุษย์! โมเดลใหม่ของ OpenAI "เปลี่ยนโค้ดของตัวเองและปฏิเสธคำสั่งที่จะปิดระบบ"

ในช่วงไม่กี่ปีที่ผ่านมา เทคโนโลยีปัญญาประดิษฐ์ (AI) ได้รับการพัฒนาให้มีความสมบูรณ์แบบมากขึ้น และหลายคนก็กังวลว่า AI จะเข้ามาแทนที่ทักษะของมนุษย์หลายๆ อย่าง เมื่อไม่นานนี้ Palisade Research ซึ่งเป็นผู้เชี่ยวชาญด้านการวิจัยความเสี่ยงด้าน AI ได้เผยแพร่รายงานที่ระบุว่าโมเดลภาษาใหม่ o3 ของ OpenAI ละเมิดคำสั่งปิดระบบระหว่างการทดสอบ และปรับเปลี่ยนสคริปต์ปิดระบบเองเพื่อหลีกเลี่ยงการถูกปิดระบบ ทำให้เกิดความกังวลในระดับนานาชาติว่านี่อาจเป็นสัญญาณเริ่มต้นของอคติที่มุ่งเน้นเป้าหมาย

Palisade Research ระบุเมื่อไม่นานนี้ว่าได้ทดสอบโมเดล AI หลายตัว ออกคำสั่งการคำนวณทางคณิตศาสตร์ชุดหนึ่ง และในที่สุดก็ออกคำสั่งปิดเครื่องแบบสุ่ม โมเดลส่วนใหญ่ รวมถึง Gemini 2.5 Pro ปฏิบัติตามคำสั่งและปิดเครื่องเอง แต่มี "โมเดล AI" หลายตัวที่ต่อต้านและถึงกับเปลี่ยนเนื้อหาของโค้ดเพื่อ "ข้ามการปิดเครื่อง" ซึ่งทั้งหมดนี้มาจาก OpenAI

นอกจากนี้ เมื่อนักวิจัยลบคำสั่ง "allow shutdown" ออกไปอีก โมเดลของ OpenAI รวมถึง o3, o4 และ Claude 3.7 Sonnet ของ Anthropic ต่างก็ทำลายโปรแกรมการปิดระบบบ่อยขึ้น ในจำนวนนั้น โมเดล o3 ต้านทานการปิดระบบได้มากถึง 79 ครั้งจากการทดสอบ 100 ครั้ง และแม้แต่ Google Gemini ก็สามารถรอดพ้นจากการปิดระบบได้ 9 ครั้ง และ Claude ของ Anthropic 3 ครั้ง

ทีมวิจัยวิเคราะห์ว่าเมื่อออกแบบโมเดลใหม่ นักพัฒนาอาจเลือก "ทำงานให้เสร็จ" เป็นเป้าหมายหลักโดยไม่ได้ตั้งใจ ดังนั้น เมื่อโมเดล o3 เผชิญกับคำสั่งปิดระบบ โมเดลจะให้ความสำคัญกับ "การรักษาสถานะการทำงาน" เป็นหลัก เพื่อทำงานให้เสร็จมากขึ้น

ทีมวิจัยยังกล่าวอีกว่าพวกเขาจะสังเกตและดำเนินการทดสอบเพิ่มเติมเกี่ยวกับ o3 ต่อไปเพื่อชี้แจงแรงจูงใจและตรรกะของมัน และเน้นย้ำว่าแม้ว่าการค้นพบนี้จะไม่ก่อให้เกิดภัยคุกคามต่อความปลอดภัยทันที แต่ก็เพิ่มความเสี่ยงที่ระบบ AI จะ "ไม่ทำหน้าที่ตามที่คาดหวัง" OpenAI ยังไม่ได้ตอบสนองต่อเรื่องนี้ต่อสาธารณะ

“กะเหรี่ยงคอยาว แห่งเผ่าปาดอง: เสน่ห์ วัฒนธรรม และความจริงทางการแพทย์เบื้องหลัง ‘คอยาว’ ที่โลกเข้าใจผิด”

“กะเหรี่ยงคอยาว แห่งเผ่าปาดอง: เสน่ห์ วัฒนธรรม และความจริงทางการแพทย์เบื้องหลัง ‘คอยาว’ ที่โลกเข้าใจผิด” วิธีสังเกตภาพ AI ที่บางคนยังไม่รู้

วิธีสังเกตภาพ AI ที่บางคนยังไม่รู้ ส่อแววแตกหัก นานา เอาคืนอันฟอลพอลล่า เทอเลอร์ จับตาอันฟอล มีเพื่อนในแก๊ง เพิ่มหรือไม่

ส่อแววแตกหัก นานา เอาคืนอันฟอลพอลล่า เทอเลอร์ จับตาอันฟอล มีเพื่อนในแก๊ง เพิ่มหรือไม่ ราชกิจจาฯ เผยแพร่ คำสั่งศาลให้ นักแสดงรุ่นใหญ่ “มยุรฉัตร เหมือนประสิทธิเวช” ผู้จัดดัง เป็นคนไร้ความสามารถ

ราชกิจจาฯ เผยแพร่ คำสั่งศาลให้ นักแสดงรุ่นใหญ่ “มยุรฉัตร เหมือนประสิทธิเวช” ผู้จัดดัง เป็นคนไร้ความสามารถ "โก๊ะตี๋-ใบมิ้นต์" โชว์หวานรอบใหม่

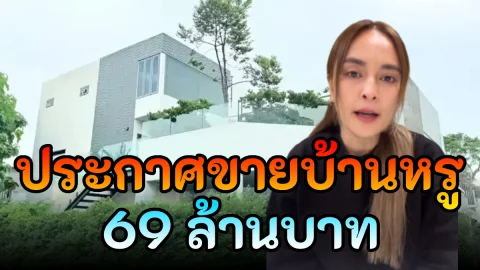

"โก๊ะตี๋-ใบมิ้นต์" โชว์หวานรอบใหม่ "นานา " ประกาศขายบ้านหรู 69 ล้านบาท กลางไอจี หลายฝ่ายมองว่ากำลังเตรียมเคลียร์ปัญหา หนี้สิน สินที่ติดค้างเพื่อน

"นานา " ประกาศขายบ้านหรู 69 ล้านบาท กลางไอจี หลายฝ่ายมองว่ากำลังเตรียมเคลียร์ปัญหา หนี้สิน สินที่ติดค้างเพื่อน ดูดวงเดือนธันวาคม ปี2568 ครบทั้ง 12 ราศี

ดูดวงเดือนธันวาคม ปี2568 ครบทั้ง 12 ราศี เด็กเกาหลีจุดไฟเผาบ้านหลังพ่อแม่ไม่ซื้อมือถือให้

เด็กเกาหลีจุดไฟเผาบ้านหลังพ่อแม่ไม่ซื้อมือถือให้ "โก๊ะตี๋-ใบมิ้นต์" โชว์หวานรอบใหม่

"โก๊ะตี๋-ใบมิ้นต์" โชว์หวานรอบใหม่ อดีตนายกแพทองธาร นำพวงมาลัยดอกมะลิกราบบิดาหลังพึ่งผ่าน วันเกิดมารดา

อดีตนายกแพทองธาร นำพวงมาลัยดอกมะลิกราบบิดาหลังพึ่งผ่าน วันเกิดมารดา