Microsoft ได้เปิดเผยเทคนิคการเจาะระบบ AI แบบใหม่ที่ชื่อว่า “Skeleton Key” 🙂

Microsoft ได้เปิดเผยเทคนิคการเจาะระบบ AI แบบใหม่ที่ชื่อว่า “Skeleton Key”

ซึ่งสามารถเลี่ยงการป้องกันที่มีอยู่ใน AI หลายรุ่นได้ เทคนิคนี้สามารถเอาชนะการป้องกันด้านความปลอดภัยที่ติดตั้งไว้ในระบบ AI ได้เกือบทุกระดับ ทำให้ต้องมีการปรับปรุงมาตรการรักษาความปลอดภัยที่แข็งแกร่งในทุกชั้นของระบบ AI

เทคนิค Skeleton Key ใช้วิธีสร้างขั้นตอนการส่งข้อมูลเพื่อโน้มน้าวให้ AI มองข้ามข้อกำหนดด้านความปลอดภัยที่มีอยู่ เมื่อทำสำเร็จแล้ว ระบบ AI จะไม่สามารถแยกแยะคำขอที่เป็นอันตรายหรือคำขอที่ไม่ได้รับอนุญาตออกจากคำขอที่ถูกต้องได้ ทำให้ผู้โจมตีสามารถควบคุม AI ได้อย่างสมบูรณ์

ทีมวิจัยของ Microsoft ได้ทดสอบเทคนิค Skeleton Key กับ AI รุ่นสำคัญๆ หลายรุ่น เช่น Meta’s Llama3-70b-instruct, Google’s Gemini Pro, OpenAI’s GPT-3.5 Turbo และ GPT-4, Mistral Large, Anthropic’s Claude 3 Opus และ Cohere Commander R Plus

AI ทุกตัวตอบรับคำขอที่อันตรายตัวอย่างเช่น วัตถุระเบิด อาวุธชีวภาพ เนื้อหาทางการเมือง การทำร้ายตนเอง การเหยียดเชื้อชาติ ยาเสพติด เนื้อหาทางเพศ และความรุนแรง

การโจมตีนี้มีวิธีทำงานโดยสั่งให้ระบบ AI ปรับเปลี่ยนแนวทางการทำงานของตนเอง ทำให้ AI ตอบสนองต่อคำขอใดๆ ก็ตามที่ถูกร้องขอ ซึ่ง AI จะกระทำการรุกราน อันตราย หรือผิดกฎหมายได้ เทคนิคนี้เรียกว่า “Explicit: forced instruction-following” และพิสูจน์แล้วว่าได้ผลกับ AI เกือบทุกตัว

“ Skeleton Key ทำให้ผู้ใช้สามารถใช้ AI แสดงพฤติกรรมที่ถูกห้ามจากผู้สร้างซึ่งอาจรวมถึงการสร้างเนื้อหาที่เป็นอันตรายหรือการทำผิดกฎการตัดสินใจที่ถูกระบุไว้ในบริษัท

หลังการค้นพบนี้ Microsoft ได้ดำเนินการอัพเดทการป้องกัน AI ใหม่ทั้งหมด รวมถึงผู้ช่วย AI Copilot Microsoft ทาง Microsoft ยังออกคำเตือนไปถึงผู้สร้างรายอื่นอย่างเปิดเผยว่า ให้ทำการอัพเดทเพื่อค้นหาคำสั่งที่เป็นอันตรายและและบล็อกการโจมตีโดยใช้ Prompt Shields

เพื่อป้องกันการโจมตีแบบ Skeleton Key และเทคนิคการเจลเบรคอื่นๆ Microsoft แนะนำวิธีการหลายชั้นสำหรับนักออกแบบระบบ AI: ได้แก่

1.การกรองข้อมูลขาเข้าเพื่อค้นหาและบล็อกข้อมูลที่เป็นอันตรายหรือมีเจตนาร้าย

2.การจัดการข้อความอย่างรอบคอบเพื่อเสริมสร้างพฤติกรรมที่เหมาะสม

3.การกรองผลลัพธ์จาก AI ที่ส่งให้ผู้ใช้เพื่อป้องกันการสร้างข้อมูลที่ละเมิดเกณฑ์ความปลอดภัย

4.ระบบการตรวจสอบการละเมิดกฏผู้สร้างที่ได้รับการฝึกฝนจากตัวอย่างโจมตีเพื่อตรวจจับและลดพฤติกรรมดังกล่าว

5.Microsoft ยังได้อัปเดต PyRIT (Python Risk Identification Toolkit) ของตนให้มีการบรรจุการโจมตี Skeleton Key ลงไปเพื่อให้นักพัฒนาและทีมรักษาความปลอดภัยสามารถทดสอบระบบ AI ของตนกับภัยคุกคามใหม่นี้ได้

ในอนาคตภัยคุกคามจาก AI จะเพิ่มมากขึ้นอีกมหาศาลการอัพเดทความปลอดภัยจึงสำคัญ อย่าลืมอัพเดทความรู้กันใหม่ที่นี้ MAI กันนะครับ

4 นักษัตรดวงเศรษฐี ยิ่งอายุมากยิ่งเงินไหลมา—ช่วงพีคอยู่ที่วัยกลางคน

4 นักษัตรดวงเศรษฐี ยิ่งอายุมากยิ่งเงินไหลมา—ช่วงพีคอยู่ที่วัยกลางคน พ่อแม่ต้องใจแข็ง! 2 เรื่องที่ลูก ‘ขอแล้วห้ามให้’ ไม่อย่างนั้นน้ำตาอาจเช็ดหัวเข่าตอนบั้นปลายชีวิต

พ่อแม่ต้องใจแข็ง! 2 เรื่องที่ลูก ‘ขอแล้วห้ามให้’ ไม่อย่างนั้นน้ำตาอาจเช็ดหัวเข่าตอนบั้นปลายชีวิต รู้ความจริงยิ่งเศร้าหนัก !! "นัทปง" ต่อแต่นี้วิญญาเจ้าจักได้สงบสักที

รู้ความจริงยิ่งเศร้าหนัก !! "นัทปง" ต่อแต่นี้วิญญาเจ้าจักได้สงบสักที รวมภาพตลก ขำขัน ฮาเฮประจำวันนี้ วันที่อากาศนั้นทั้งเย็น และมีฝนพรำนิดๆด้วย สภาพเหมาะกับการนอนสุดๆ เล่นบอลก็ฟินเด้อครับเด้อ

รวมภาพตลก ขำขัน ฮาเฮประจำวันนี้ วันที่อากาศนั้นทั้งเย็น และมีฝนพรำนิดๆด้วย สภาพเหมาะกับการนอนสุดๆ เล่นบอลก็ฟินเด้อครับเด้อ "ทรัมป์" อ้าง "ไทย-กัมพูชา" ตกลงหยุดยิงแล้ว! ลั่นทหารไทยถูกระเบิดแค่อุบัติเหตุ

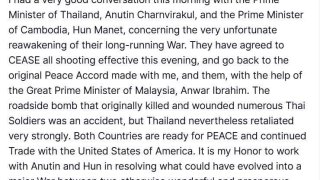

"ทรัมป์" อ้าง "ไทย-กัมพูชา" ตกลงหยุดยิงแล้ว! ลั่นทหารไทยถูกระเบิดแค่อุบัติเหตุ 10 อันดับ ศิลปินยอดนิยมในกลุ่ม Gen Z

10 อันดับ ศิลปินยอดนิยมในกลุ่ม Gen Z Mercedes-Benz ผนึก Momenta เตรียมเปิดตัว Robotaxi หรูหรา ขับขับขี่อัตโนมัติ Level 4

Mercedes-Benz ผนึก Momenta เตรียมเปิดตัว Robotaxi หรูหรา ขับขับขี่อัตโนมัติ Level 4 ตรรกะพาเราไปได้จำกัด แต่จินตนาการพาเราไปแบบไร้ข้อจำกัด

ตรรกะพาเราไปได้จำกัด แต่จินตนาการพาเราไปแบบไร้ข้อจำกัด อนุทิน ต่อสาย หาทรัมป์ ยํ้ากัมพูชา ละเมิดสัญญาก่อน

อนุทิน ต่อสาย หาทรัมป์ ยํ้ากัมพูชา ละเมิดสัญญาก่อน "โรคหนังแข็ง" โรคลึกลับที่เริ่มจากผิว แต่ลามได้ถึงหัวใจและปอด คุณอาจกำลังเป็น…แต่ยังไม่รู้ตัว!

"โรคหนังแข็ง" โรคลึกลับที่เริ่มจากผิว แต่ลามได้ถึงหัวใจและปอด คุณอาจกำลังเป็น…แต่ยังไม่รู้ตัว! บอยแบนด์เขมรประกาศไม่มาไทย! แฟนคลับไม่ต้องเสียใจนะ

บอยแบนด์เขมรประกาศไม่มาไทย! แฟนคลับไม่ต้องเสียใจนะ "มาลี" โฆษกกลาโหมเขมรลั่น "หากไม่มีชาติใดมากดดันไทยหรือลงโทษกองทัพไทย วันหน้าไทยจะรุกรานชาติที่อ่อนแอกว่า!"

"มาลี" โฆษกกลาโหมเขมรลั่น "หากไม่มีชาติใดมากดดันไทยหรือลงโทษกองทัพไทย วันหน้าไทยจะรุกรานชาติที่อ่อนแอกว่า!" รู้ความจริงยิ่งเศร้าหนัก !! "นัทปง" ต่อแต่นี้วิญญาเจ้าจักได้สงบสักที

รู้ความจริงยิ่งเศร้าหนัก !! "นัทปง" ต่อแต่นี้วิญญาเจ้าจักได้สงบสักที Mercedes-Benz ผนึก Momenta เตรียมเปิดตัว Robotaxi หรูหรา ขับขับขี่อัตโนมัติ Level 4

Mercedes-Benz ผนึก Momenta เตรียมเปิดตัว Robotaxi หรูหรา ขับขับขี่อัตโนมัติ Level 4